Spark在Win10下的环境搭建

时间:2018-06-24 来源:互联网 浏览量:

版本说明

jdk:1.8

scala:2.11.8

spark:2.3.0

hadoop:2.8.3

环境准备

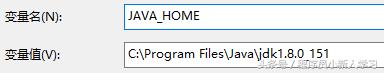

jdk配置

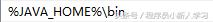

1、配置JAVA_HOME与Path:

Path

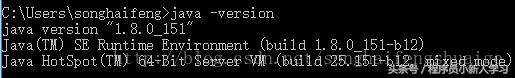

2、验证配置:

scala安装与配置

1、scala下载:

访问官方地址http://www.scala-lang.org/download/2.11.8.html

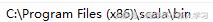

2、配置Path:

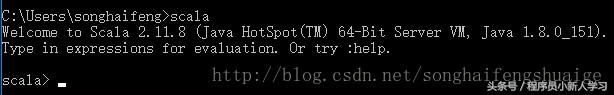

3、验证配置:

Spark安装与配置

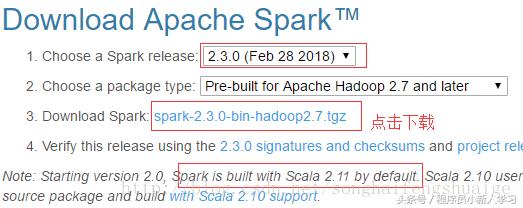

1、spark下载:

访问官方地址http://spark.apache.org/downloads.html

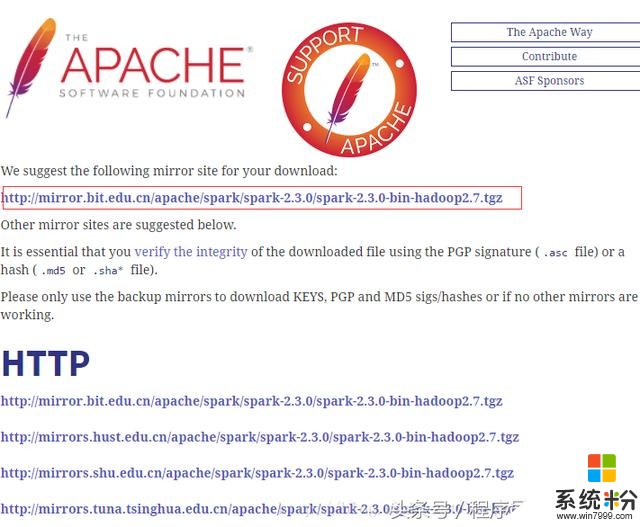

选中官方推荐的地址即可下载,其他地址也可用(建议采用迅雷等下载工具下载,速度比较会快很多)

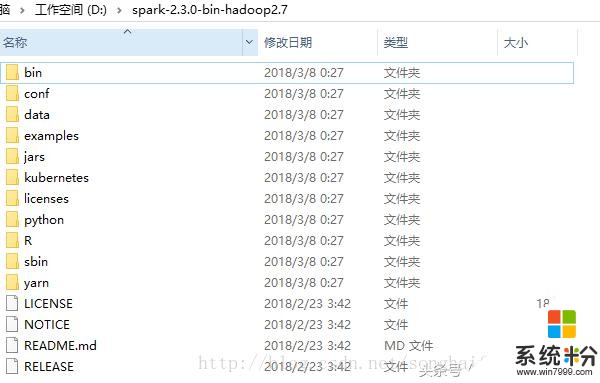

2、解压至D盘;

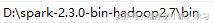

3、配置Path:

4、通过spark-shell进入Spark的交互式命令行模式:

如上,可以看到对应的spark、scala、java版本,同时也看到了异常信息,该异常信息是由于hadoop导致的,下面来配置hadoop。

Hadoop安装与配置

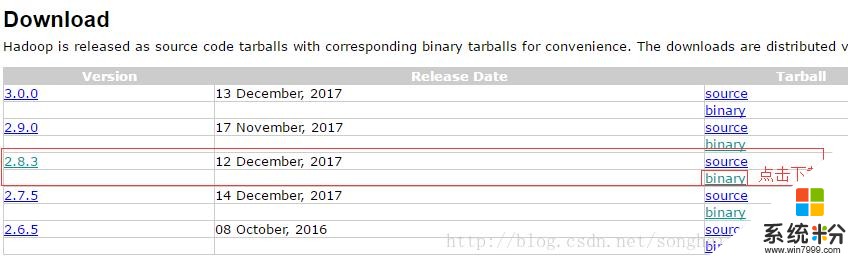

1、hadoop下载

访问官方http://hadoop.apache.org/releases.html

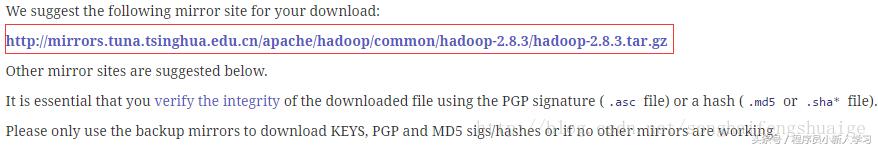

进入下载页,如下建议地址(同样建议用迅雷等下载工具下载,速度更快)

2、解压至

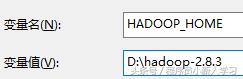

3、配置HADOOP_HOME&Path:

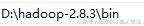

path:

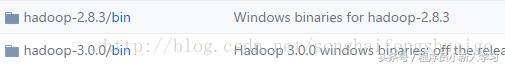

4、winutils下载:https://github.com/steveloughran/winutils

下载对应版本的bin目录直接替换本地bin目录即可。

5、此时继续spark-shell进入spark命令行交互模式:

此时即不会出现上述的异常提示。

6、访问控制台中的webui如下:

我要分享:

相关资讯

热门手机应用

最新热门游戏

微软资讯推荐

- 1 Win10全新分支版本曝光 微软或针对高端PC进行优化!

- 2 升级Windows 10创意者更新后罗技摄像头罢工:这样解决

- 3 人脸识别世界杯 微软百万名人识别竞赛冠军出炉 现实应用指日可待

- 4“赶尽杀绝”?微软官宣5月12日Win10将不再接收安全更新

- 5微软发布Surface Laptop背后打的什么算盘?

- 62017微软技术暨生态大会召开 本土化产品闪亮登场

- 7新版Win10后又一大招, 微软开设MR工作室、MR学院!

- 8终于等到:微软正为Win10文件管理器打造黑暗主题

- 9育碧下狠手!Windows 10盗版系统无法运行Uplay平台

- 10用户报告Win10新正式版不兼容雷蛇笔记本